Summary

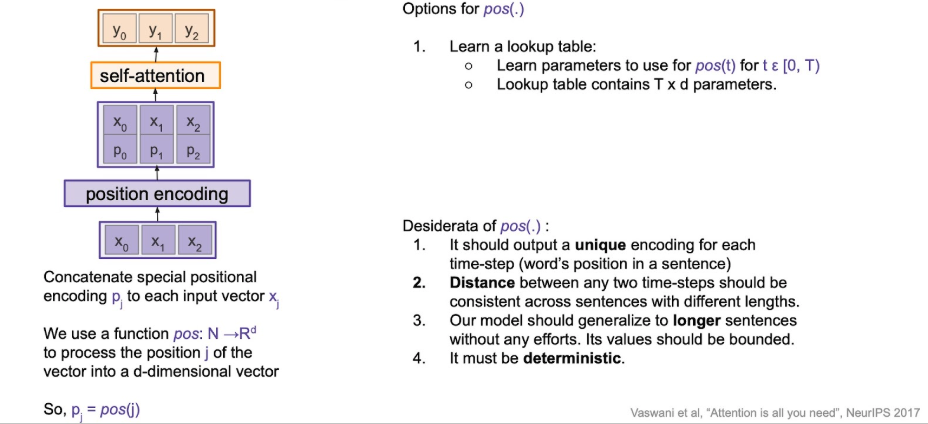

input seq에 대한 순서 정보를 encoding 하는 게 목적.

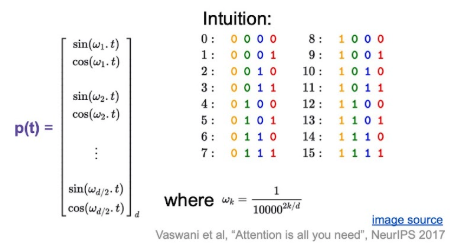

transformer에서는 아래와 같이 sine-cosine을 사용해서 fixed encoding 함.

Question

Why sine | cosine?

- 덧셈 정리 같은 걸 사용하면, 특정 offset 위치를 선형함수로 표현할 수 잇으니, 모델 입장헤서 학습하기 쉬워, 상대적 거리를 학습할 수 잇을 것이라 기대 가능.

- Extrapolation : train-set보다 더 긴 문장이 들어와도, 주기 함수를 사용하면, fixed된 rule에 따라 이에 해당하는 positional vector를 만들어낼 수 있어, 유연하게 대처할 수 있을 것이라 기대.