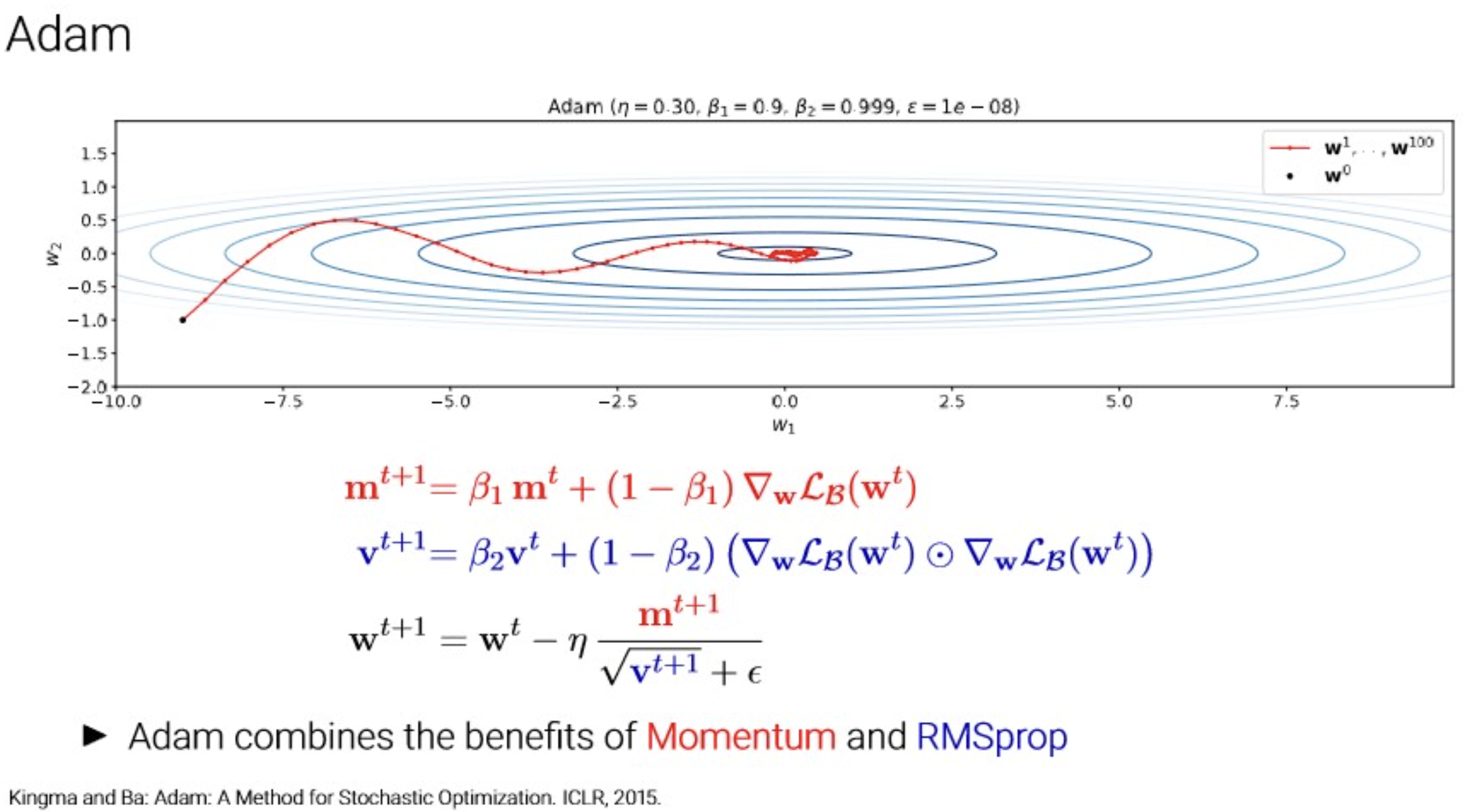

Adam?

Key Contibution

RMSProp에서는 EMA(Exponential moving Average) 개념.

- gradient에 대한 EMA를 모멘텀 개념으로 해석.

- 1차, 2차 gradient(제곱) 형태의 모멘텀을 사용해서 파라미터 업데이트.

AdaGrad에서는 per-parameter lr의 철학을 계승해서 구현됨.

- 파라미터 직접 업데이트 식에서 분모에 들어가는 scaling factor로 gradient의 2차 값을 사용.

추가로 bias-correection 까지.

- 학습 초기시, EMA 특성으로 초기값은 m, v 값이 0에서 잘 움직이지 않는 것을 보정해주는 작업.

파생형인 AdamW는 LLM에서 현재(2025)까지 goldeen standard로 자리잡고 있음.

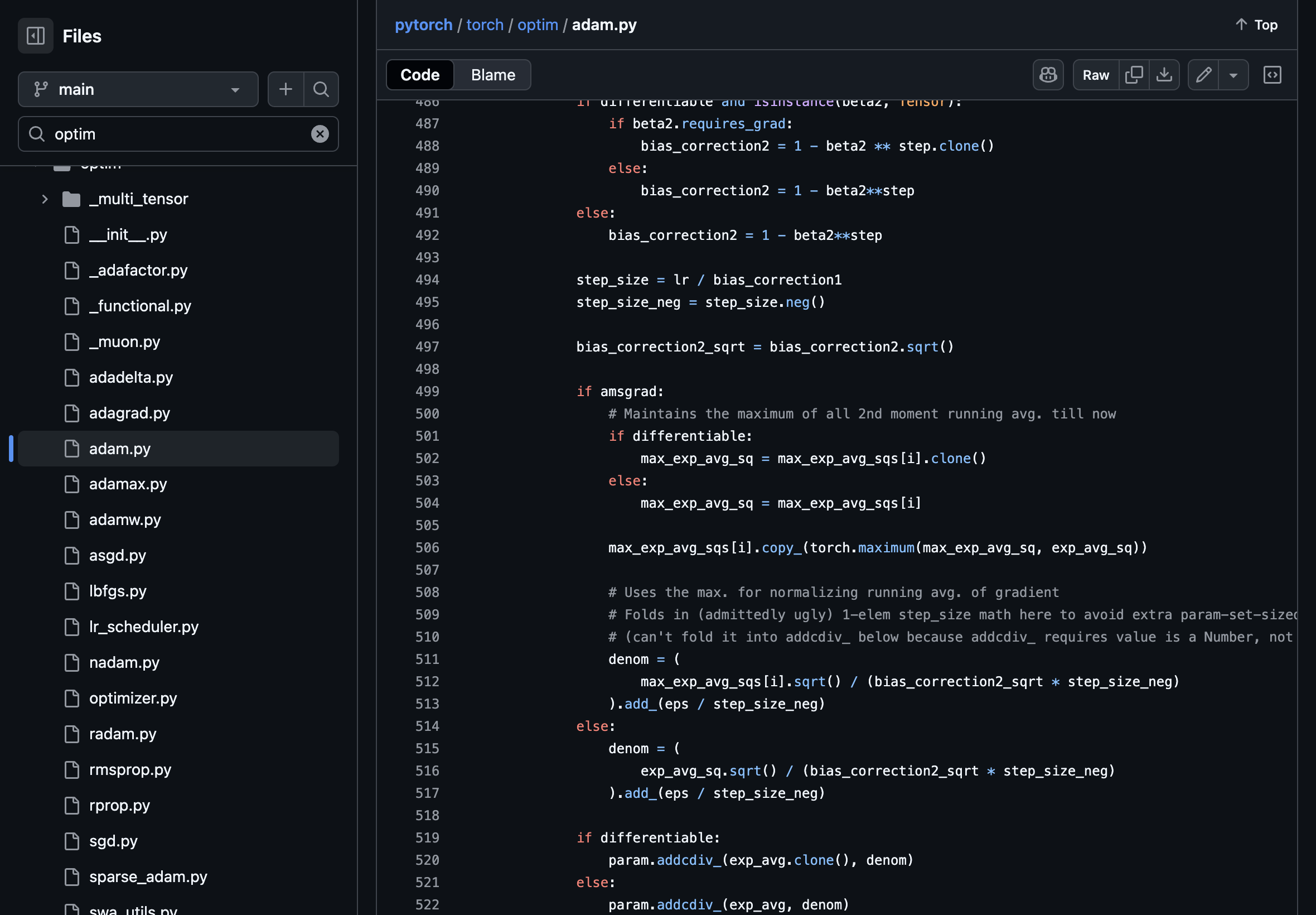

- adam이 RMSProp + Momentum이니, 실제 코드를 뜯어보면,

moving average 전용 함수가 따로 구현되어 있고 사용하는게 보이네,,,

https://losslandscape.com/explorer

위와 같은 시각화 툴 한 번 찾아볼 것.