Summary

ChatGPT가 어떻게 학습되었는지 다루는 paper.

‘chat’이라는 목적을 다루는만큼, human-preference를 align해주는 framework 구축.

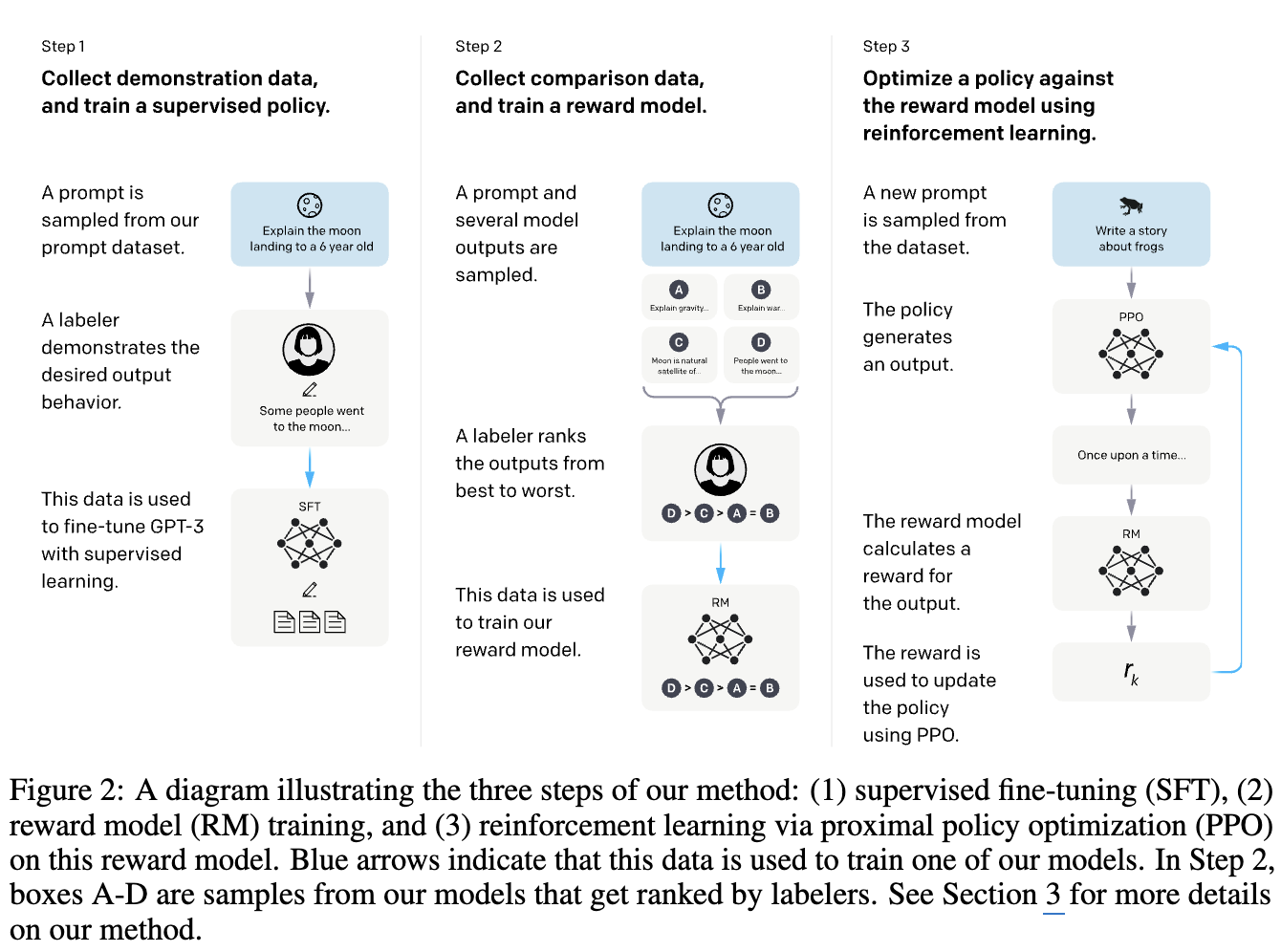

Reinforcement Learning with Human Feedback(RLHF) 개념 정립 및 결과도 긍정적으로 확인할 수 있었음.학습 framework를 SFT → Reward modeling → RLFH with PPO

3 step으로 제안.

실무 팁

- Alignment Tax와 PPO-ptx 목적 함수의 설계

- 단순히 RLHF를 적용하면 모델이 특정 지시 수행 능력은 좋아지지만, 일반적인 NLP 벤치마크(예: SQuAD, DROP)의 성능이 떨어지는 현상이 발생하는데, 이를 논문에서는 **“Alignment Tax(정렬 세금)“**라고 함.

- 이를 해결하기 위해 저자들은 PPO 단계에서 사전 학습(Pre-training) 시의 로그 확률(Log Likelihood)을 손실 함수에 섞는 PPO-ptx 방식을 제안함.

\begin{align*}\text{objective}(\phi) &= E_{(x,y) \sim D_{\pi_{\phi}^{RL}}} [r_{\theta}(x, y) - \beta \log(\pi_{\phi}^{RL}(y|x) / \pi^{SFT}(y|x))] + \gamma E_{x \sim D_{\text{pretrain}}} [\log(\pi_{\phi}^{RL}(x))]\end{align*}

- 매개변수 효율성 (1.3B vs 175B)

“모델의 크기가 정렬(Alignment)을 보장하진 않는다”.

1.3B 매개변수의 InstructGPT 모델의 결과물이 175B의 기본 GPT-3 결과물보다 인간 라벨러들에게 더 선호됨.

- 미학습 Domain에 대한 Zero-Shot

- 훈련 데이터의 대부분이 영어이고, 코드 작성과 관련된 내용은 적었는데, 학습 후

- 프랑스어도 잘했고,

- 코드 작성도 쫌 함.

즉, 뭔가 generalization에 대한 skill 을 배웠다고 반증됨.