Introduction

Summary

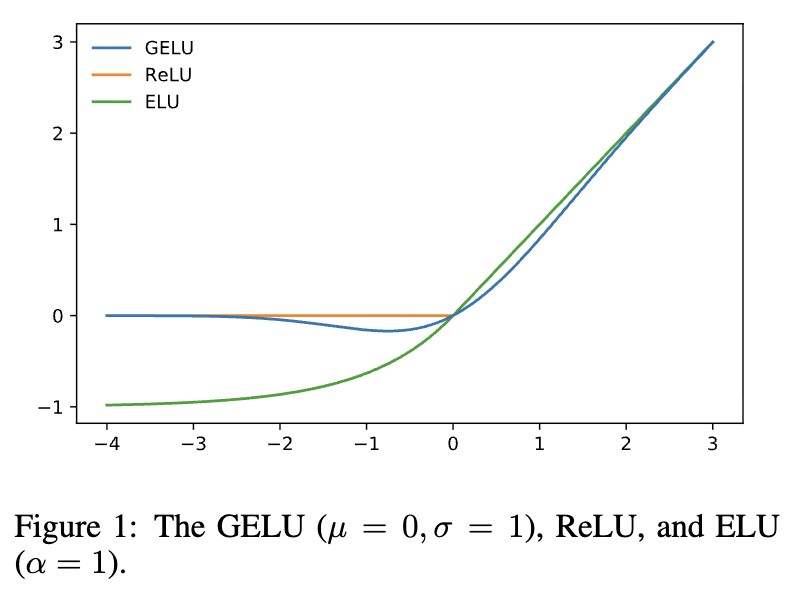

ReLU, ELU 와 같은 deterministic한 activation에 dropout과 같은 확률적 정규화 방법을 합침.

formula :Idea : input 에 mask 을 곱하자.

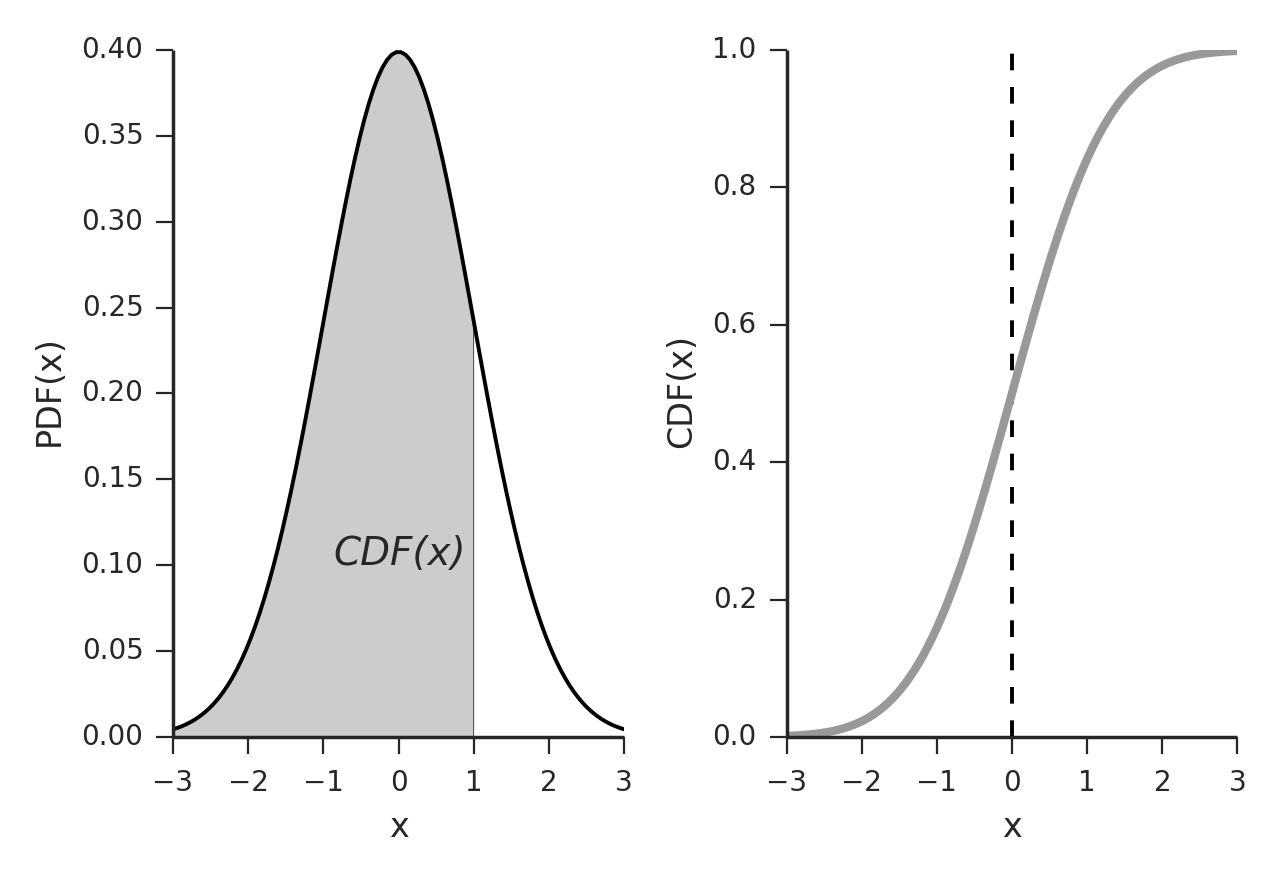

- where

- : 의 CDF(Cumulative Density Function)

연산 속도를 위해 다음과 같은 근사식을 사용하기도 함.

하나 더!

위처럼, Normal distribution이 아니라, logistic function의 CDF를 사용하면, SiLU라고 함.

Discussion

- Momentum을 사용하는 optimizer와 추천.

- GELU가 non-convex하고, non-monotonic하니, momentum을 사용하는 optimizer를 사용해서 gradient가 더 빈번히 변하는 걸 control.