Summary

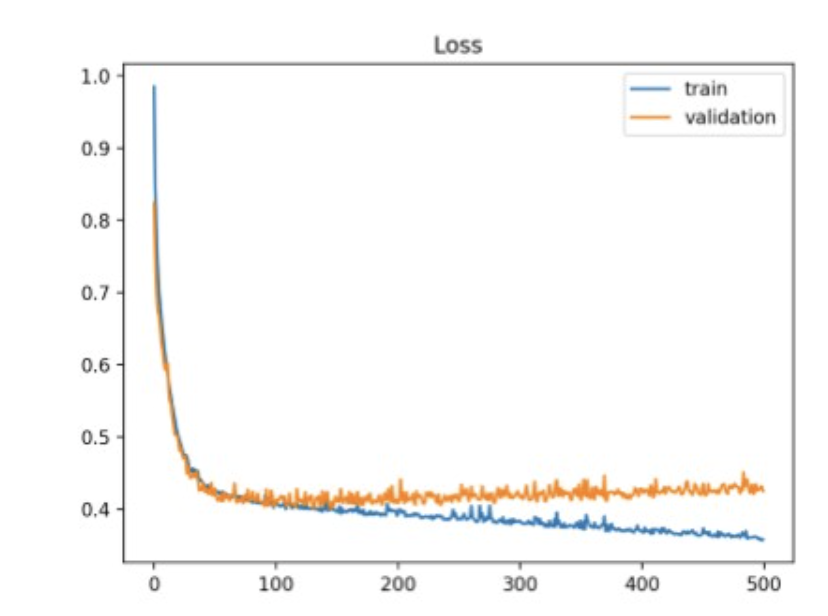

Training loss는 계속 줄지만, validation loss은 낮아지지 않음.

train을 계속하면, 모델은 train-set에만 잘 작동하는 함수로 fitting되니,

generalization이 떨어지고, validation-set 또는 unseen-data에 대해서도 loss가 커짐.

Help

To solve the problem, several methods are recommended.

- Get more data: 사실상 이게 best. 그러나 cost-issue.

모델한테 패턴을 학습할 기회를 더 주는 것.- Data Augmentation : 데이터를 더 collecting 하는 것 보단 현실적.

train-set의 diversity를 주는 것.- Better Data: low-quality data를 remove.

- Transfer Learning: task-suit 하게 준비된 set으로 fine-tune.

- Simplify model: 모델의 capacity가 충분해서 train-set의 너무 과한 패턴을 학습한 거니, 모델의 복잡성을 줄여서 generalization performance 확보.

- Learning Rate decay: fine-tune은 학습 후반에서 미세한 gradient에서 학습하는 거니, decaying은 후반에서 이러한 것들을 완화해줌.

- Early Stopping: overfit 되기 전에 stop.