Summary

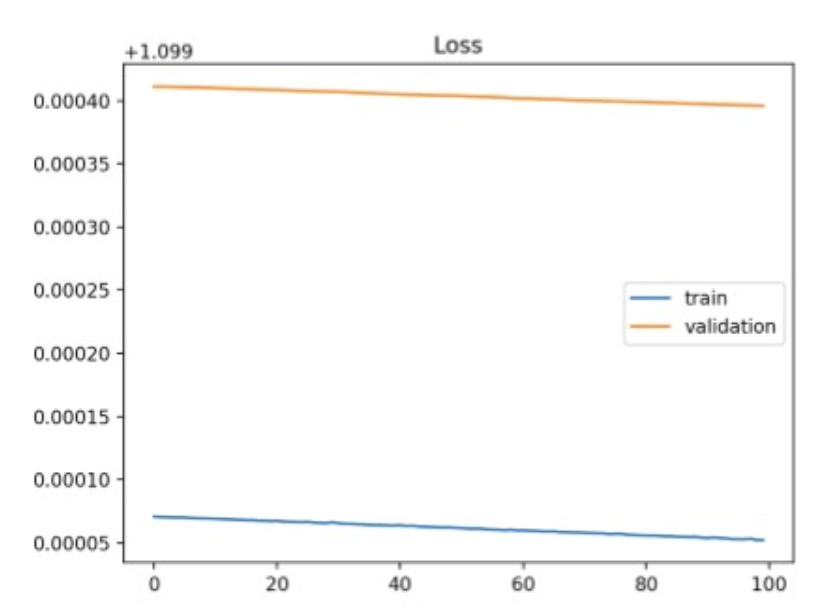

모델이 더 이상 충분히 loss 를 줄이지 못함.

Training loss가 validation loss에 비해 낮음. → model의 capacity가 충분치 못함.

Capacity vs Complexity

Capacity: 이론적으로 모델이 표현할 수 있는 function space의 크기

Complexity: 실제 학습된 모델의 표현력

Help

To solve the problem, several methods are recommended.

- Add more layer/units to model: model의 capacity의 부족으로 인한 문제를 직접적으로 해결.

- Tweak the learning rate : 기존에 잡힌 lr이 너무 커도 underfit이 되기도 하니, 줄여보고 판단.

lr이 초기에 너무 커버리면, 아예 학습이 진행되지 않은 경우가 될 수도 있어서 이게 underfit 개형으로 보이는 것.- train for longer: 더 해보면 될 수도?

- Transfer Learning: underfit의 요인 중 하나로 빈약한 representation을 꼽을 수 있고, 이는 이미 representation이 풍부한 pre-trained model에서 가져와서 수정하는 것으로 어느 정도 완화할 수 있음.

- use less regularization: regularization 즉, penalty를 너무 tight하게 잡아서 모델의 학습이 지지부진한 걸 수도. 이때에는 오히려 penalty를 완화시켜서 접근.