Regularization

Let

만일 우리가 를 만족하는 파라미터 를 찾았다고 한다면, 그게 unique할까?

→ Nope. 도 동일하게

Regularization: prevent the model from doing too well on training data. overfitting을 피하려는 전략 중 하나. 수식으로 보자면,

앞의 term이 Data Loss, 뒤의 term 이 penalty, regularization term.

model complexity가 커지면, generalization 관점에서 모델이 너무 train set에만 익숙해져 이를 피하려고 regularization을 사용.

Occam's Razor

“Simple is the best.”

Among the multiple competing hypotheses, the simplest is the best.

Examples

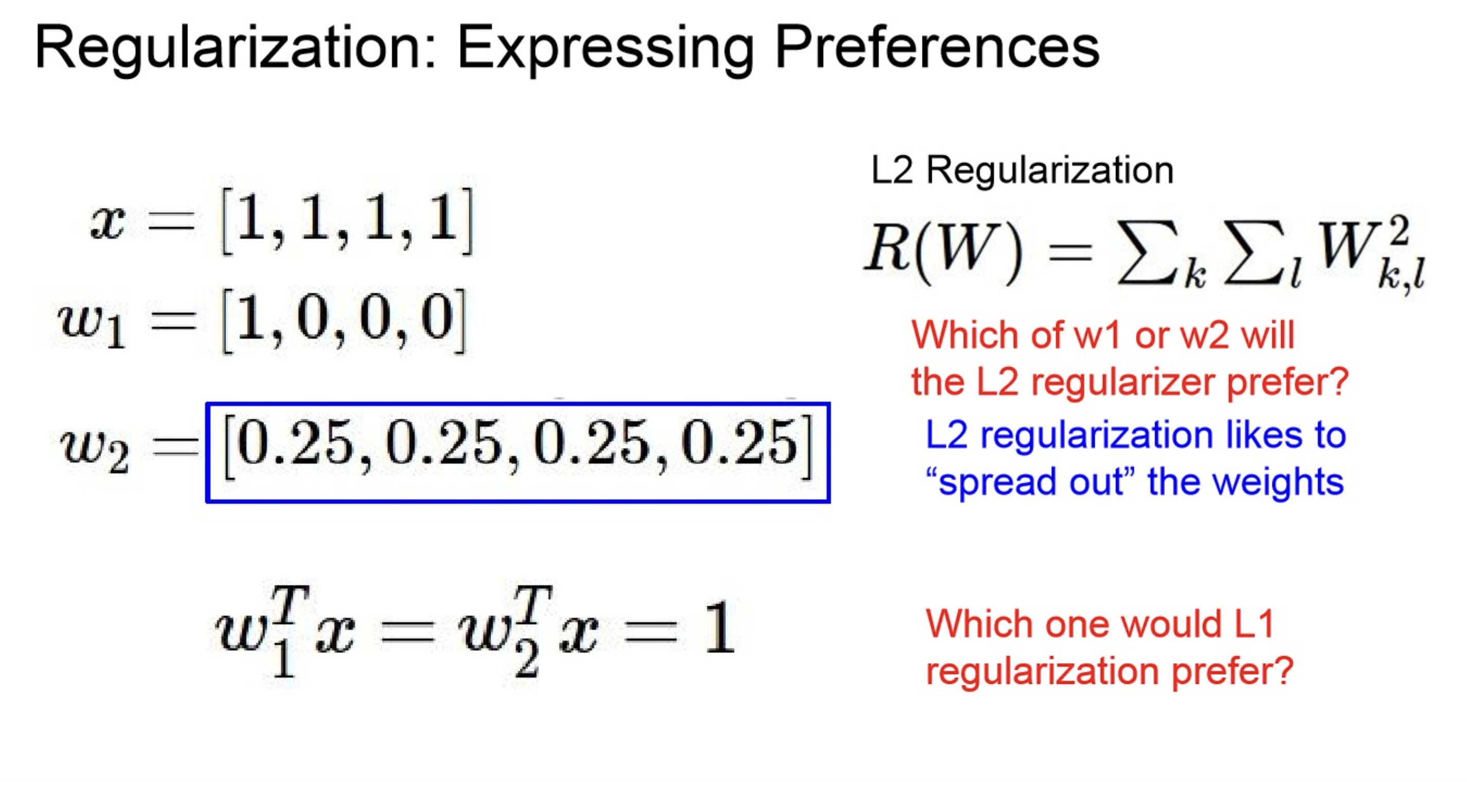

L2-Regularization

L1-Regularization

Elastic-Net(L1 + L2)

Why Regularization?

- Express preferences over weights

- Make the model simple so it works on test data

- Improve optimization by adding curvatures

Regularization - parameter preference

위 상황에서 는 uniform한 , 은 sparse한 을 더 선호한다.